Actualidad

Twitter lanza «modo seguro» para proteger y bloquear a los hater.

Twitter y otras plataformas de redes sociales a menudo enfrentan críticas por no hacer lo suficiente para abordar el acoso y el discurso de odio, especialmente contra las mujeres y las minorías.

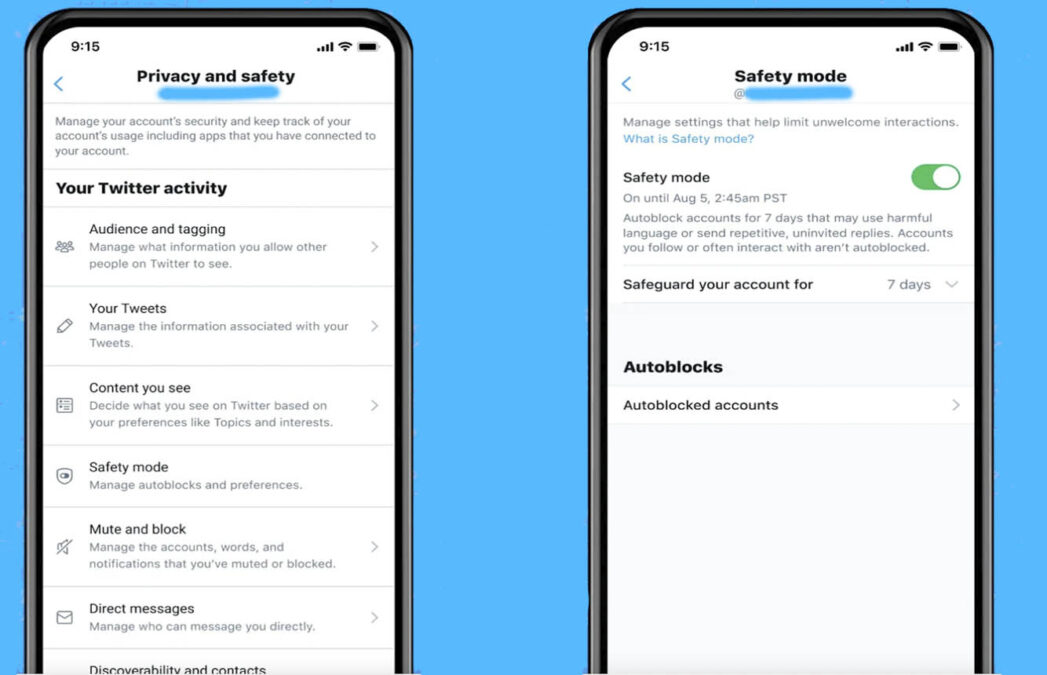

Este «modo seguro» («safety mode«, en inglés) es una función que bloquea temporalmente (7 días) las cuentas que usen un «lenguaje potencialmente nocivo», como insultos, comentarios odiosos o «menciones repetitivas y no solicitadas»

«Nuestra tecnología tiene en cuenta las relaciones existentes, por lo que las cuentas que sigue o con las que interactúa con frecuencia no se bloquearán automáticamente», escribió un ejecutivo de Twitter en una publicación de blog.

Las cuentas autobloqueadas no podrán seguir la cuenta del autor del tweet, ver sus tweets o enviarles mensajes directos durante siete días. Twitter dijo que está implementando la función para un pequeño grupo en iOS, Android y el sitio web Twitter.com, a partir de hoy con cuentas que tienen habilitadas las configuraciones en inglés.

Twitter está implementando la función ‘Modo de seguro’ que tiene como objetivo reducir las interacciones disruptivas al bloquear temporalmente las cuentas durante siete días por usar lenguaje dañino o enviar respuestas no invitadas. El miércoles, la compañía de medios sociales dijo que su sistema evaluará la «probabilidad de un compromiso negativo» mediante el análisis del contenido del tweet y la relación entre el autor del tweet y quienes lo responden.

La función será probada inicialmente por un pequeño número de usuarios de habla inglesa, dijo Twitter, y se dará prioridad a las «comunidades marginadas y periodistas mujeres» que a menudo son víctimas de abusos.

«Queremos hacer más para reducir la carga de las personas que enfrentan interacciones no deseadas», dijo Twitter en un comunicado, y agregó que la plataforma está comprometida a albergar «conversaciones saludables».

Dijo Twitter

Al igual que otros gigantes de las redes sociales, Twitter permite a los usuarios informar sobre publicaciones que consideran odiosas, incluidos mensajes racistas, homofóbicos y sexistas.

Pero los activistas se han quejado durante mucho tiempo de que los agujeros en la política de Twitter permiten que los comentarios violentos y discriminatorios permanezcan en línea en muchos casos.

La plataforma está siendo demandada en Francia por seis grupos antidiscriminatorios que acusan a la empresa de fallas «a largo plazo y persistentes» para bloquear los comentarios de odio.

El Modo de seguridad es la última de una serie de funciones introducidas para brindar a los usuarios de Twitter más control sobre quién puede interactuar con ellos. Las medidas anteriores han incluido la capacidad de limitar quién puede responder a un tweet.

Twitter dijo que la nueva función era un trabajo en progreso, consciente de que podría bloquear accidentalmente mensajes que de hecho no fueran abusivos.

«No siempre lo haremos bien y podemos cometer errores, por lo que los bloqueos automáticos del Modo de seguridad se pueden ver y deshacer en cualquier momento en su Configuración», dijo la compañía.

Para evaluar si un mensaje debe bloquearse automáticamente, el software de Twitter tomará señales del idioma, así como de las interacciones previas entre el autor y el destinatario.

Twitter dijo que había consultado a expertos en seguridad en línea, salud mental y derechos humanos mientras desarrollaba la herramienta.

ARTICLE 19, un grupo de derechos digitales con sede en el Reino Unido que participó en las conversaciones, calificó la función como «otro paso en la dirección correcta para hacer de Twitter un lugar seguro para participar en la conversación pública sin temor a abusos».

El anuncio se produjo después de que Instagram presentó el mes pasado nuevas herramientas para frenar el contenido abusivo y racista, luego de una serie de comentarios de odio dirigidos a los futbolistas después de la Eurocopa.